Inhalt des Kurses

Invention Design 1

Interaktionsgestaltung

Semesterjahr3. Semester

Feet: eine Studie zu fußbasierter Interaktion mit taktilem Feedback

In unserer Arbeit in Invention Design I analysierten wir den historischen Kontext von Fußinteraktionen und versuchten moderne Nutzungskontexte für die Anwendung von fußbasierter Interaktion zu finden.

Ausführlicher Artikel bald auch auf Englisch verfügbar.

Historischer Anwendungen von Fußinteraktionen

Wir interessierten uns am Thema der Fußinteraktionen, da, obwohl Gestensteuerung und User Experience seit einer Weile relevante Themen sind, es kaum Konzepte zu Fußinteraktionen gibt. Entweder hat sich bisher noch niemand darüber Gedanken gemacht, oder es wurde bereits untersucht und mithilfe valider Usertests als untauglich und im Alltag unbrauchbar eingestuft.

Da es bei einer Interaktion immer auf den Kontext ankommt, lässt sich nicht ohne Weiteres sagen inwiefern eine Fußinteraktion relevant für eine Primär- oder Sekundärinteraktion wäre.

Im Allgemeinen wurde der Fuß in der Vergangenheit nur genutzt um sehr einfache lineare Funktionen zu erfüllen. Meist sind die Hände hier beschäftigt und der Blick darf nicht von der Primäraktion genommen werden.

Beispiele hierfür wären die Arbeit an einer Nähmaschine oder an einem Spinnrad. Auch heutzutage wird zum Transkribieren von Audioaufnahmen Pedale verwendet, die eine schnelle Steuerung der Aufnahmen ermöglichen. Ebenfalls aktuell ist die Anwendung des Gaspedals in Kraftfahrzeugen, denn hier handelt es sich eben um ein sehr komplexes System, bei dem Hände und Augen entscheidende Funktionen erfüllen.

Die Rolle des Fußes beschränkt sich also auf die Steuerung von niederkomplexen Sekundärfunktionen.

Moderne Nutzungskontexte

Unser Ziel war es nun, Fußinteraktionen in einen modernen Kontext zu setzen: Durch Tracking können nun auch explizite Gesten ausgeführt werden; in digitalen Systemen können diese mit einer Vielzahl von Funktionen belegt werden.

Fokus/Arbeitsplatz

Ein Flow-Erlebnis kann entstehen, wenn ein Nutzer sich gefordert, jedoch nicht überfordert fühlt. Zeit und Umgebung werden ausgeblendet und der Nutzer geht voll in seine Tätigkeit ein. Er ist extrem fokussiert. Eine Änderung der Körperhaltung, wie das Greifen nach einer Maus und deren Verwendung, enorm störend ist.

In Nutzungskontexten, die schnelles Tippen erfordern und in denen der Nutzer stark auf seine Tätigkeit fokussiert ist, bieten sich fußbasierte Interaktionen daher an.

Entspannung/Abstand/Zu Hause

Neben den Phasen in denen hochkonzentriertes Arbeiten notwendig ist, gibt es auch Situationen, in denen ein Nutzer Abstand zu seiner Tätigkeit gewinnen möchte – physisch zum Reflektieren oder psychisch zum Entspannen. Sitzt der Nutzer also entspannt und zurückgelehnt ist es für ihn besonders einfach die Füße für Interaktionen zu nutzen, da auf diesen nicht viel Gewicht lastet. Allein aufgrund der Physiognomie befinden sie sich häufig näher am Bildschirm als alle anderen Extremitäten, sie können also einfach getrackt werden.

Außerdem bieten sich fußbasierte Interaktionen in Nutzungskontexten an, in denen der Nutzer eine entspannte Körperhaltung hat und Abstand vom Bildschirm sucht.

Fokus unserer Entwicklung

Recherche

Diese drei Studien zu fußbasierter Interaktion, gaben uns einen guten Einblick in Studien. In verschiedenen Kontexten (Laborumgebung um Gesten zu verifizieren, im Zusammenspiel mit einer Tabletop-Multitouch Umgebung und unterwegs in Verbindung mit mobilen Spielen) wurde fußbasierte Interaktion untersucht.

Unmittelbarkeit: Erlebbarkeit, Rückmeldung und Verifizierbarkeit

Die Idee der digitalen Fußsteuerung als primäre Steuerung ist eine neuartigen Bedienungsmethode, welche es in dieser Weise noch nicht gegeben hat. So entstanden sehr verschiedene Interaktionskonzepte und Theorien zur Bedienbarkeit. Wir brauchten also eine unmittelbare Erlebbarkeit, um, über ausführliches Testen, unsere Ideen und erdachten Konzepte verifzieren zu können. Aufgrund dieser Vorraussetzungen entschieden wir uns, die Umsetzung in Eigenregie zu programmieren. Nur so konnten wir alle Parameter der Interaktionen steuern und somit sinnvolle Ergebnisse erzielen.

Technologie

Tracking

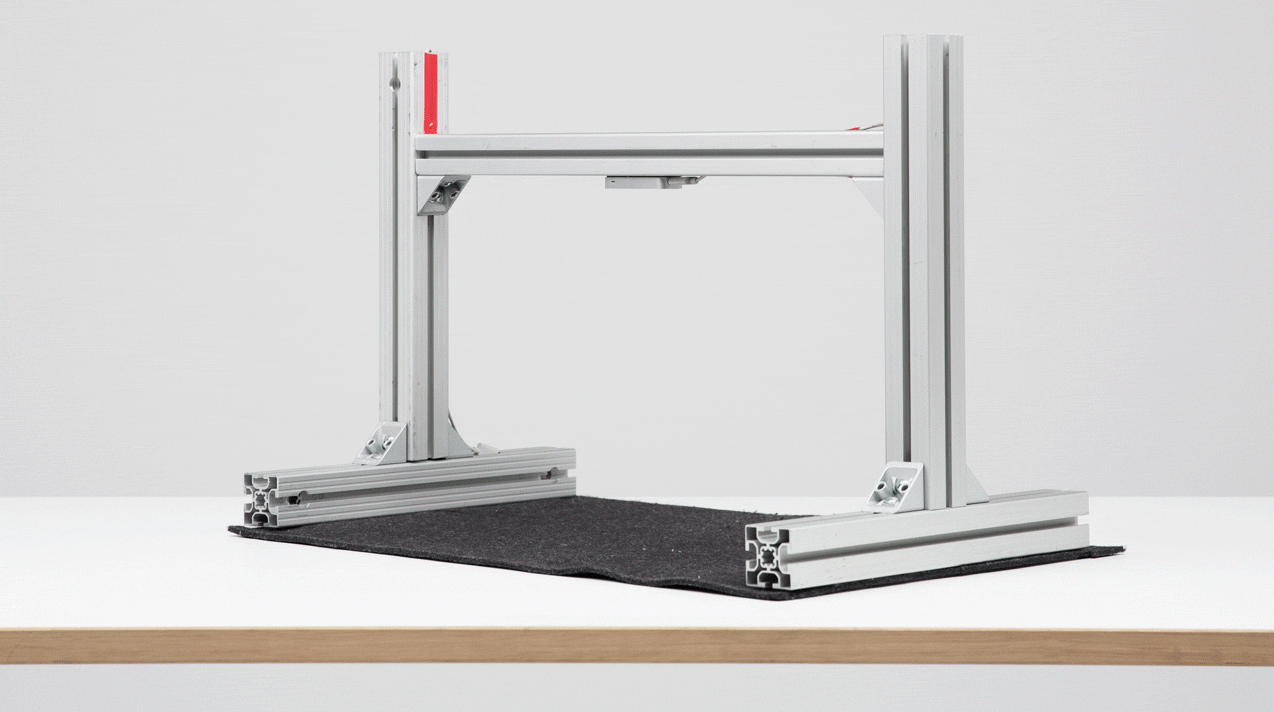

Wir nutzten für unsere Überlegungen eine LeapMotion, die wir kopfüber an Bosch-Profilen befestigten. So konnten wir den Fuß im dreidimensionale Raum verfolgen. Während der Entwicklungszeit befestigten wir eine Hand am Fuß des Nutzers um stetigere Daten zu bekommen.

Um möglichst viel Kontrolle über das Tracking zu besitzen, entschlossen wir uns, eine eigene Bibliothek zum Verarbeiten der von der LeapMotion gelieferten Daten zu schreiben.

Die Bibliothek ist auf Github frei verfügbar.

Taktiles Feedback

In den letzten Jahren lag der Fokus bei Interfaces verstärkt auf dem visuellen Feedback, da die visuelle Wahrnehmung die für den Menschen relevanteste darstellt. Auditives und haptisches bzw. taktiles Feedback wurde im Vergleich zu den Entwicklungen im visuellen Bereich vernachlässigt. Auch hier fragten wir uns, was Gründe dafür sein könnten und gelangten nach langer Recherche und ersten Testphasen zu der Erkenntnis, dass das Erstellen von intuitiv verständlichen Patterns für auditiv-taktiles Feedback, sogenannten Sound-Icons, schwierig ist, da sich der subjektive Eindruck von Individuum zu Individuum zum Teil sehr stark unterscheidet. Es lässt sich ohne Kontext nicht einmal festlegen, was als positives bzw. negatives Feedback wahrgenommen werden kann. Diese Sound-Icons müssen in spezifischen Kontexten vom Nutzer erst erlernt werden.

Das taktile Feedback kann daher nicht für sich alleine stehen und muss, um den bestmöglichen Effekt zu erzielen, synchron mit dem visuellen Feedback laufen. Das taktile Feedback wird durch gesättigte Sinuswellen mit Sägezahnanteilen erzeugt und über ein, in einem Kissen eingebauter, Bodyshaker an das Zwerchfell des Nutzers weitergegeben.

Nutzerzentrierte Einführung

Da dies ein komplett neues Bedien- und Erlebniskonzept ist, können wir Nutzer nicht direkt in unsere Anwendungsbeispiele stoßen. Unser Ziel war es, über eine nutzerzentrierte Einführung, das Erlernen der Interaktionen zu vereinfachen. Dazu waren verschiedene Schritte der Komplexitätssteigerung notwendig.

1. Entwickeln eines Raumgefühls

Im ersten Abschnitt kann der Nutzer keine Fehler machen. In verschiedenen Bereichen, die der Nutzer durch ein einfaches neigen seines Fußes entdecken kann, werden dem Nutzer die Grenzen des visuellen und taktilem Feedback aufgezeigt.

2. Einführung von Selektion

Im zweiten Bereich werden die Patterns für die Selektion eingeführt. Auch hier wird der Nutzer zu Beginn nicht überfordert und beginnt mit einem einfachen Überfahren von Auswahlmöglichkeiten.

Im weiteren Verlauf lernt der Nutzer das er Elemente auswählen und durch ein herunterziehen anschalten kann.

3. Einführung von Swipes: Schaffen eines mentalen Modells der Interaktion

Das Modell des Swipes bricht mit den vorherigen Abschnitten. Ziel dieses Abschnittes ist es, ein mentales Modell der Interaktion eines Swipes zu schaffen. Der Nutzer steuert einen Punkt, der sich zwischen zwei Linien befindet. Um daraus auszubrechen, muss der Nutzer eine ruckartige Bewegung nach links oder rechts machen. Durch das Variieren der Schwierigkeit lernt der Nutzer diese Gesten kennen.

Zukunftsvisionen

Wir haben uns verschiedene Anwendungsszenarien ausgedacht, in denen fußbasierte Interaktionen hilfreich sein könnten. Über ausführlichere Testreihen müsste man diese Aussagen und Modelle noch verifizieren.

Bildergalerie

Eine Demonstration, die wir in der Zeit des Projektes umsetzen konnten, ist eine Bildergalerie, bei der durch Swipes nach links und rechts Bilder betrachtet werde können. Durch eine Auswahl können sie zusätzlich favorisiert und gelöschten werden. Hier wären auch noch weiter Funktionen denkbar, wie das Bewerten der Bilder oder das Einsortieren in Kategorien.

Mailclient

Ein Mailclient könnte, wie die Bildergalerie, eine entspannte Stapelbearbeitung erlauben. Über Fußgesten kann der Nutzer Mails lesen, verschieben oder markieren. Aus dem inhaltlichen Kontext der Mail generierte Funktionen, wie das Eintragen eines Termins oder das Abspeichern von Kontaktdetails wären ebenfalls leicht erreichbar.

Textediting

Ein Beispiel mit einem Nutzungskontext im Fokus-Bereich wäre das Textediting oder eine Schreibumgebung. Durch sehr einfache kleine Gesten wäre es möglich ohne große Ablenkung Funktionen für das Bearbeiten von Textteilen möglich. So könnte der Nutzer sehr einfach das letzte Wort markieren, oder es z.B. durch einen Tap als Überschrift setzen. Weiterhin wären auch das Löschen des zuletzt geschriebenen Wortes oder Absatzes denkbar. In diesem Bereich ist besonders die Nutzergruppe der Programmierer interessant, da diese bereits häufg eine Vielzahl an Tastenkürzeln verwenden und sehr auf eine Optimierung ihres Workfows bedacht sind.

Betriebsystemsteuerung

Um ebenfalls nicht aus dem Fokus zu fallen, wären Fußinteraktionen auch geeignet um Betriebssystemfunktionen wie das Wechseln zwischen Programmen oder zwischen Desktops zu steuern. Auch die Steuerung eines Musik-Player, bei der der Nutzer die Hauptandienung nicht verlassen muss wäre denkbar.

Gadgets

“Tweet with your Feet” oder “Feetexplorer for Facebook” wären zwei Möglichkeiten die Fußgesten in einem etwas freieren Kontext zu nutzen: Nutzer könnten ihre eignen Streams mit den Füßen durchswipen und Beiträge liken, bzw. retweeten.

Christoph Labacher, Nikolas Klein, Werner Schaefner

BetreuungProf. David Oswald, Prof. Joerg Beck

VeröffentlichungWintersemester 2014 / 15

Tags